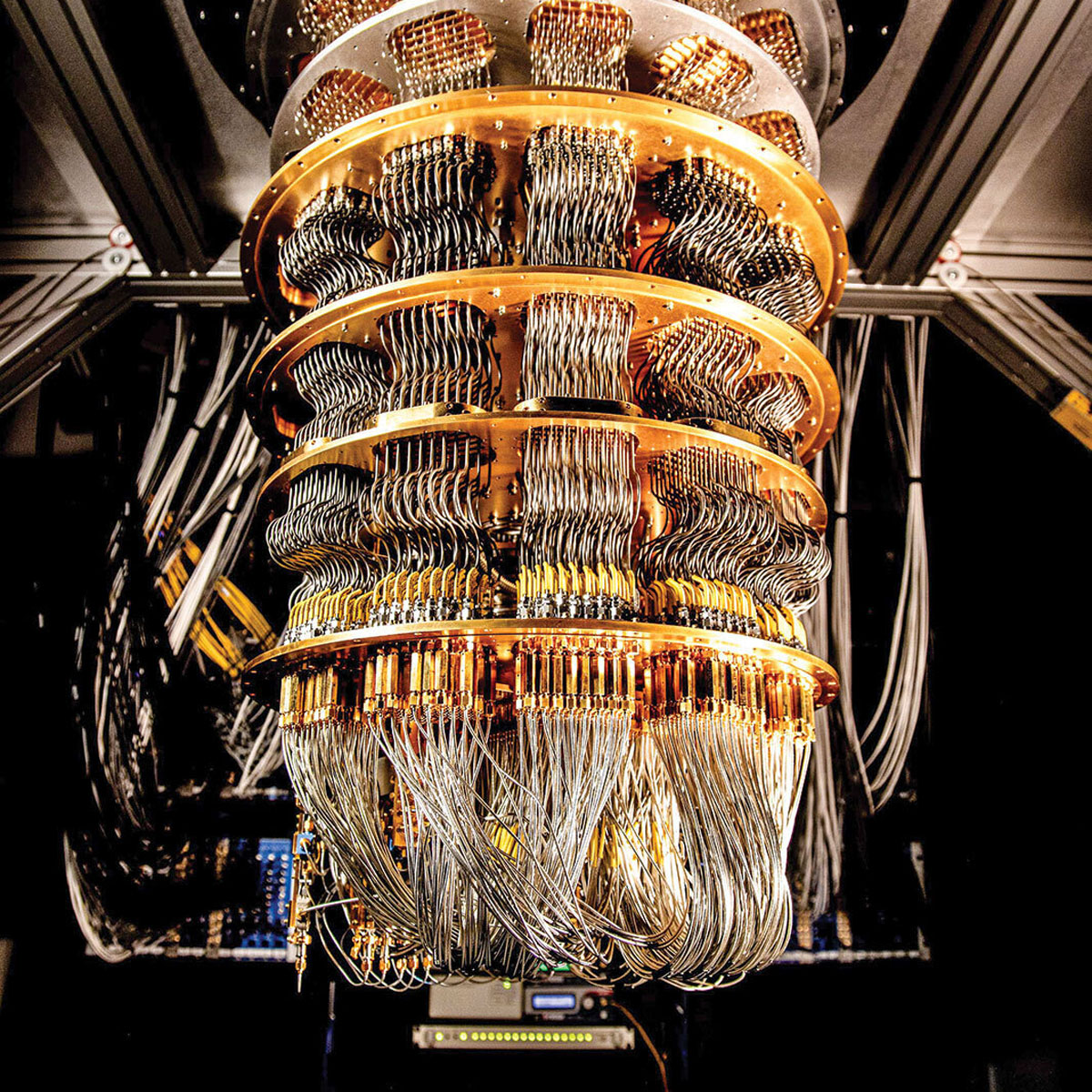

در کامپیوترهای کلاسیک با استفاده از کپی کردن اطلاعات یک بیت در بیتهای اضافی و مقایسه آنها پس از انجام فرآیند محاسبات، میتوان خطا را تشخیص داد و در نتیجه آن را تصحیح کرد.اما در کامپیوترهای کوانتومی قضیه متفاوت است. طبق قوانین مکانیک کوانتومی کپی کردن حالت یک کیوبیت امکانپذیر نیست، بنابراین تشخیص خطا در کامپیوترهای کوانتومی روشهای مخصوص خود را دارد.به عنوان مثال، یک کیوبیت را در حالت 0 و 1 در نظر بگیرید. با استفاده از درهم تنیدگی، می توان دو کیوبیت دیگر را با آن درهمتنیده کرد که در حالت نهایی هر سه 0 و به طور همزمان هر سه 1 هستند (000-111) حالا اگر مثلاً دومین کیوبیت از این سه کیوبیت دچار خطا شود، حالت به 010-101 تبدیل می شود. برای تشخیص چنین خطایی، محققان کیوبیتهای فرعی را بین کیوبیت اول و دوم و دوم و سوم در همتنیده میکنند. اندازهگیری روی آن کیوبیتهای «فرعی»، کیوبیت دارای خطا را در سه کیوبیت اصلی نشان میدهد، در حالیکه کیوبیت های اصلی هرگز اندازهگیری نشدهاند.اکنون، تیم هوش مصنوعی کوانتومی گوگل پروتکل تصحیح خطایی را اثبات تجربی کرده است که وقتی اطلاعات کیوبیت منطقی بین کیوبیتهای فیزیکی بیشتری پخش میشود، احتمال رخداد خطا کمتر میشود. این تیم با استفاده از یک تراشه 72 کیوبیتی، یک کیوبیت منطقی را به دو صورت رمزگذاری کرد - یا در یک شبکه 17 کیوبیتی (نه کیوبیت اصلیو هشت کیوبیت فرعی) یا 49 کیوبیت (25 اصلی و 24 فرعی). محققان هر شبکه را در 25 چرخه اندازه گیری قرار دادند و به دنبال کیوبیت های دارای خطا گشتند. در نهایت دانشمندان مشاهده کردند که با افزایش تعداد کیوبیت نرخ خطا نیز کاهش مییابد.

لینک خبر: https://www.nature.com/articles/d41586-022-04532-4